Ein bemerkenswertes Ereignis in der KI-Landschaft, Mistral AI's Mixtral 8x7B sticht als signifikanter Fortschritt heraus. Dieses Open-Source-Modell für große Sprachmodelle (LLM) ist mehr als nur eine neue Ergänzung; es ähnelt einem lokalen, Mini GPT-4.

Mixtral 8x7B: Eine kompakte Version von GPT-4

Mixtral 8x7B ist eine kompakte und effiziente Version von GPT-4 und bietet fortgeschrittene KI-Fähigkeiten in einer handlicheren und zugänglicheren Form.

Indem es eine ähnliche Architektur von Mixture of Experts (MoE) in einem verkleinerten Format übernimmt, stellt Mistral AI eine praktische Alternative für verschiedene Anwendungen dar.

Wichtige Aspekte von Mixtral 8x7B:

- Struktur: Nutzt 8 Experten mit jeweils 7 Milliarden Parametern im Vergleich zur größeren Skala von GPT-4.

- Effiziente Verarbeitung: Verwendet nur 2 Experten pro Token für die Inferenz und spiegelt somit die Effizienz von GPT-4 wider.

Technische Parameter:

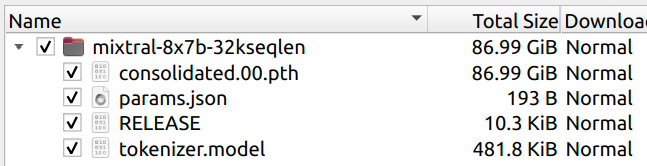

- Größe: Das Modell ist 87GB groß und kleiner als ein 8x Mistral 7B, was auf gemeinsame Aufmerksamkeitsparameter zur Größenreduktion hinweist.

- Vergleich mit GPT-4: Bietet eine Reduzierung um das 2-fache der Anzahl an Experten und um das 24-fache der Parameter pro Experten, was zu einer geschätzten Gesamtzahl von 42 Milliarden Parametern führt.

Kontextkapazität:

- Behält eine Kontextgröße von 32K bei, ähnlich zu GPT-4, um eine robuste Leistung zu gewährleisten.

Warum reden alle über Mistral AI's neuesten LLM Drop?

- Entwickelt von Mistral AI: Dieses in Paris ansässige Startup hat Aufmerksamkeit erregt, indem es technisches Fachwissen mit Open-Source-Zugänglichkeit kombiniert hat.

- Auswirkungen auf die KI-Industrie: Die Veröffentlichung von Mixtral 8x7B signalisiert einen Paradigmenwechsel, herausfordernde Industrienormen und fördert die Demokratisierung in der KI-Technologie.

- Mehr als nur eine Ergänzung zu KI-Leistungen: Mixtral 8x7B geht über die Verbesserung der Liste von KI-Innovationen hinaus. Es stellt bestehende Standards in Frage und eröffnet neue Möglichkeiten für Innovation und Exploration.

- Wegbereiter für offene, zugängliche KI: Der Ansatz von Mistral AI mit Mixtral 8x7B setzt neue Maßstäbe für Offenheit und Zusammenarbeit in der KI-Entwicklung.

Download Mixtral 8x7B Torrents

Anstelle der üblichen aufwändigen Veröffentlichungen hat Mistral AI einen einzigartigen Weg für Mixtral 8x7B gewählt und es über Torrent-Links veröffentlicht.

Hier sind die Torrent-Links zum Download des neuesten Mixtral 87XB-Modells:

magnet:?xt=urn:btih:208b101a0f51514ecf285885a8b0f6fb1a1e4d7d&dn=mistral-7B-v0.1&tr=udp%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce&tr=https%3A%2F%https://t.co/HAadNvH1t0%3A443%2Fannounce

RELEASE ab979f50d7d406ab8d0b07d09806c72c

magnet:?xt=urn:btih:5546272da9065eddeb6fcd7ffddeef5b75be79a7&dn=mixtral-8x7b-32kseqlen&tr=udp%3A%2F%http://2Fopentracker.i2p.rocks%3A6969%2Fannounce&tr=http%3A%2F%http://2Ftracker.openbittorrent.com%3A80%2Fannounce

RELEASE a6bbd9affe0c2725c1b7410d66833e24

Dieser Ansatz steht im starken Kontrast zu den durchinszenierten Veröffentlichungen von Unternehmen wie Google und OpenAI und konzentriert sich eher darauf, eine Aussage zu machen, als ein Spektakel zu inszenieren.

Die unkonventionelle Veröffentlichung hat nicht nur die Fähigkeiten des Modells hervorgehoben, sondern auch Gespräche über die Zukunft der KI-Technologie und die Rolle von Open-Source-Modellen angeregt.

Mistral vs Google pic.twitter.com/mJSJ252nga

— Manoj Mahalingam (@manojlds) 8. Dezember 2023

Interessiert an der Entwicklung von KI-Anwendungen ohne Code?

Du solltest Anakin AI ausprobieren - eine No-Code-Plattform, mit der du Apps unter Verwendung von KI-Modellen wie GPT-4, Claude-2.1, DALLE-3, Stable Diffusion und vielem mehr erstellen kannst!

Wie funktioniert Mixtral 8x7B?

Beim Eintauchen ins Herz von Mixtral 8x7B findet man ein Wunderwerk moderner KI-Technik, ein Beweis für die Expertise und Vision von Mistral AI. Dieses Modell ist mehr als nur ein kleineres Geschwistermodell des weit verbreiteten GPT-4; es ist ein raffiniertes, effizientes und zugängliches Werkzeug, das für sich selbst steht.

Mixtral 8x7B basiert auf dem Prinzip eines Mixture of Experts (MoE)-Modells, ein Konzept, das in den letzten Jahren aufgrund seiner Effizienz und Skalierbarkeit an Bedeutung gewonnen hat. Speziell besteht Mixtral 8x7B aus 8 Experten, von denen jeder 7 Milliarden Parameter besitzt, was eine deutliche Verkleinerung im Vergleich zu den vermuteten 8 Experten von GPT-4 mit jeweils 111 Milliarden Parametern darstellt. Diese Designentscheidung macht Mixtral nicht nur in Bezug auf die Rechenanforderungen handlicher, sondern auch für verschiedene Anwendungen geeignet.

Die Architektur von Mixtral 8x7B ist besonders faszinierend. Sie ist für die Token-Inferenz konzipiert und verwendet nur 2 der 8 Experten, was die Verarbeitungseffizienz und -geschwindigkeit optimiert. Dieser Ansatz spiegelt sich in den Modellmetadaten wider und liefert tiefere Einblicke in seine Konfiguration:

{

"dim": 4096,

"n_layers": 32,

"head_dim": 128,

"hidden_dim": 14336,

"n_heads": 32,

"n_kv_heads": 8,

"norm_eps": 1e-05,

"vocab_size": 32000,

"moe": {

"num_experts_per_tok": 2,

"num_experts": 8

}

}

Diese Konfiguration zeigt eine fortgeschrittene Einrichtung mit einem hochdimensionalen Einbettungsraum (dim: 4096), mehreren Schichten (n_layers: 32) und einer beträchtlichen Anzahl an Heads für Aufmerksamkeitsmechanismen (n_heads: 32). Die MoE-Architektur ("moe": {"num_experts_per_tok": 2, "num_experts": 8}) unterstreicht den Fokus des Modells auf effiziente, spezialisierte Verarbeitung für jedes Token.

Eine der bemerkenswertesten Aspekte von Mixtral 8x7B ist seine Fähigkeit, hoch entwickelte KI-Funktionen bereitzustellen, während es deutlich zugänglicher ist als seine größeren Pendants. Diese Zugänglichkeit bezieht sich nicht nur auf die Benutzerfreundlichkeit, sondern auch auf die für den Betrieb erforderlichen Rechenressourcen. Die im Vergleich zu einer hypothetischen 8-fachen Skalierung von Mistral 7B reduzierte Größe des Modells wird durch gemeinsame Aufmerksamkeitsparameter erreicht, eine clevere Designwahl, die die Gesamtgröße des Modells erheblich reduziert, ohne die Leistung zu beeinträchtigen.

Auch die Implementierung von Mixtral 8x7B in praktischen Anwendungen ist bemerkenswert. Das Design des Modells ermöglicht eine flexible Anpassung an verschiedene Computerumgebungen, von High-End-Servern bis hin zu bescheideneren Einrichtungen. Hier ist ein Einblick, wie Mixtral 8x7B implementiert werden kann:

python example_text_completion.py Pfad/zum/mixtral/ Pfad/zum/mixtral/tokenizer.model

In diesem einfachen Befehl repräsentiert example_text_completion.py ein Skript, das das Mixtral 8x7B-Modell nutzt, wobei die Pfade auf die Modell- und Tokenizer-Dateien verweisen. Diese einfache Implementierung zeigt das Engagement von Mistral AI, fortschrittliche KI-Technologie zugänglicher und benutzerfreundlicher zu machen.

Sie können die Mixtral 8x7B Hugging Face-Seite von jemandem hier besuchen:

Mixtral 8x7B steht als ein leistungsstarkes, aber zugängliches Werkzeug in der KI-Landschaft. Seine technische Raffinesse in Kombination mit seinem pragmatischen Design machen es nicht nur zu einem beeindruckenden LLM, sondern auch zu einem Vorbild dafür, wie zukünftige KI-Modelle aussehen könnten - kraftvoll, effizient und für eine breitere Palette von Benutzern und Anwendungen erreichbar.

Mixtral 8x7B ausführen - zwei aktuelle Methoden

Methode 1: Mixtral 8x7B mit diesem Hack ausführen

Für diejenigen, die sofort mit Mixtral 8x7B experimentieren möchten, gibt es eine etwas unorthodoxe, aber funktionale Methode. Dieser Ansatz besteht darin, den ursprünglichen Llama-Code so anzupassen, dass er mit Mixtral 8x7B funktioniert. Es ist jedoch wichtig zu beachten, dass diese Implementierung noch in den Anfangsstadien ist und möglicherweise nicht das volle Potenzial des Modells ausschöpft.

Wichtige Punkte des Hacks:

Naiv und langsam: Die Implementierung ist zugegebenermaßen einfach und nicht für Geschwindigkeit optimiert.

- Hardwareanforderungen: Für diese Version werden entweder zwei 80GB-GPUs oder vier 40GB-GPUs benötigt.

- Technische Details: Die Methode beinhaltet das Entfernen der Modellparallelität zur Vereinfachung und das Aufteilen der Experten auf die verfügbaren GPUs. Sie umfasst auch eine rückentwickelte MoE-Implementierung basierend auf diesem Forschungspapier.

Implementierung:

Die Gewichte herunterladen: Die Mixtral-Modellgewichte sind entweder über Torrent oder vom Hugging Face-Repository unter Mixtral 8x7B auf Hugging Face verfügbar.

Ausführen des Modells: Sobald Sie die Gewichte haben, können Sie das Modell auf 2 GPUs (je etwa 45 GB benötigend) mit dem folgenden Befehl ausführen:

python example_text_completion.py Pfad/zum/mixtral/ Pfad/zum/mixtral/tokenizer.model

Für eine 4-GPU-Konfiguration fügen Sie dem Befehl --num-gpus 4 hinzu.

Methode 2: Verwenden Sie die Fireworks.ai-API, um Mixtral 8x7B auszuführen

Eine alternative, benutzerfreundlichere Möglichkeit, Mixtral 8x7B zu testen, besteht über die Fireworks.ai-Plattform. Diese Plattform bietet ein reibungsloses Erlebnis, obwohl zu beachten ist, dass dies keine offizielle Implementierung von Mistral AI ist.

Wichtige Merkmale von Fireworks.ai:

- Schneller Zugriff: Das Modell ist nur Stunden nach der Veröffentlichung der Gewichte einsatzbereit und zeigt die Agilität und den gemeinschaftlichen Geist der KI-Gemeinschaft.

- Rückentwickelte Architektur: Die Implementierung auf Fireworks.ai wurde durch Reverse Engineering der Architektur anhand der Parameterbezeichnungen in Zusammenarbeit mit der Community erreicht.

Verwendung von Fireworks.ai: - Zugriff auf das Modell: Besuchen Sie einfach Fireworks.ai, um Mixtral 8x7B auszuprobieren.

- Einschränkung: Benutzer sollten sich bewusst sein, dass dies keine offizielle Veröffentlichung ist und daher die Ergebnisse variieren können. Updates werden erwartet, sobald Mistral AI den offiziellen Modellcode veröffentlicht.

Mistral AI: das beste KI-Unternehmen der Stadt

Die Veröffentlichung von Mixtral 8x7B hat die KI-Gemeinschaft in Aufruhr versetzt und unterschiedliche Reaktionen hervorgerufen, die ihre Bedeutung verdeutlichen. Enthusiasten, Experten und Entwickler haben sich zu Wort gemeldet und die Auswirkungen des Modells aus verschiedenen Blickwinkeln hervorgehoben.

Positive Resonanz und konstruktive Kritik: Die Reaktionen waren größtenteils positiv, wobei viele Mistral AI für ihren innovativen Ansatz und die technischen Fähigkeiten des Modells lobten.

Uri Eliabayev, ein KI-Berater, lobte Mistral für ihre gewagte Veröffentlichungsstrategie

George Hotz, ein bekannter Unternehmer, äußerte seine Wertschätzung für die Marke Mistral, die er als Favoriten im KI-Bereich betrachtet.

Google hat eine Pressemitteilung und eine gefälschte Demo veröffentlicht.

— George Hotz 🌑 (@realGeorgeHotz) 8. Dezember 2023

Mistral hat einen Torrent veröffentlicht. https://t.co/K3qKWLWQBE

Diese Begeisterung wird durch konstruktive Kritik abgemildert, die hauptsächlich auf die Begrenzungen des Modells im Vergleich zu größeren Pendants wie GPT-4 abzielt, doch selbst diese Kritiken erkennen das Potenzial von Mixtral 8x7B an.

Am wichtigsten ist jedoch die starke Wertschätzung der KI-Gemeinschaft für das Bekenntnis von Mistral AI zu Open-Source-Prinzipien. Dieser Ansatz wurde als Schritt zur Demokratisierung der KI-Technologie und zur Erreichbarkeit einer breiteren Palette von Benutzern und Entwicklern gelobt.

Mistral AI: Neue Standards für Open Source LLMs mit Mixtral 8x7B

Wenn wir in die Zukunft schauen, wird der Einfluss von Mixtral 8x7B auf die KI-Landschaft immer deutlicher. Der Ansatz von Mistral AI bei der Veröffentlichung und Gestaltung von Mixtral 8x7B könnte neue Standards für die Entwicklung und Verbreitung von KI-Modellen setzen.

Mixtral 8x7B steht für einen bedeutenden Schritt in Richtung mehr Open-Source-Lösungen in der KI.

Sein Erfolg könnte weitere Unternehmen dazu inspirieren, ähnliche Ansätze zu übernehmen und möglicherweise zu einer vielfältigeren und innovativeren KI-Forschungsumgebung führen.

Wie verändert Mixtral 8x7B von Mistral AI die Zukunft der KI- und LLM-Entwicklung?

Die begeisterte Aufnahme von Mixtral 8x7B und die dadurch entstandenen Gespräche deuten auf einen wachsenden Trend hin, der zu einer offeneren und kooperativeren KI-Entwicklung führt. Dieses Modell bietet nicht nur ein wertvolles Werkzeug für verschiedene Anwendungen, sondern eröffnet auch neue Möglichkeiten für Innovation, Erkundung und Diskussionen im Bereich der KI.

In Zukunft wird Mixtral 8x7B voraussichtlich eine entscheidende Rolle bei der Gestaltung der KI-Zukunft spielen. Seine Auswirkungen werden voraussichtlich über verschiedene Branchen und Gemeinschaften hinweg spürbar sein und weitere Fortschritte vorantreiben sowie den Zugang zu hochmoderner KI-Technologie demokratisieren. Zusammenfassend lässt sich sagen, dass Mixtral 8x7B nicht nur ein Meilenstein für Mistral AI ist, sondern ein Meilenstein für die gesamte KI-Gemeinschaft, der einen Wandel hin zu einer inklusiveren, kooperativen und offenen KI-Entwicklung signalisiert.

Interessiert am Entwickeln von KI-Apps ohne Code?

Du solltest Anakin AI ausprobieren - eine No-Code-Plattform, mit der du Apps mit KI-Modellen wie GPT-4, Claude-2.1, DALLE-3, Stable Diffusion und vielem mehr erstellen kannst!

from Anakin Blog http://anakin.ai/blog/mixtral-8x7b-de/

via IFTTT

No comments:

Post a Comment